Il y a quelques années, une photo floue restait une photo floue. On pouvait l’accentuer un peu dans Photoshop, jouer avec les curseurs de netteté, espérer un miracle. En général, ça donnait quelque chose de granuleux et d’artificiel, pire que l’original. Les photographes professionnels connaissent bien cette frustration : le cliché parfait, le bon moment, la bonne lumière, mais un bougé de 1/30e de seconde qui fout tout en l’air.

Ce temps-là est révolu. Pas complètement, soyons honnêtes, mais les outils d’ia amelioration photo ont franchi une étape que personne n’aurait vraiment prédite il y a cinq ans. Les modèles d’intelligence artificielle dédiés à la restauration d’image ne se contentent plus de « deviner » les contours manquants : ils reconstruisent des détails plausibles à partir d’une base d’apprentissage colossale.

La restauration photo par IA reconstruit les détails perdus à partir de modèles entraînés sur des millions d’images.

Sommaire :

Pourquoi les photos deviennent floues ou pixelisées

Avant de comprendre comment l’IA corrige ces défauts, il faut savoir d’où ils viennent. Le flou n’est pas une catégorie unique : il y a le flou de bougé (mouvement de l’appareil ou du sujet pendant la pose), le flou de mise au point (sujet hors du plan focal), et le flou de défocalisation optique (lentille de piètre qualité ou objectif mal réglé). Chacun a une signature différente dans les données de l’image, et les algorithmes d’IA sont désormais capables de les distinguer.

La pixelisation, elle, vient d’un autre problème : une résolution insuffisante. Quand on agrandit une photo de 500×500 pixels pour l’afficher en 2000×2000, le logiciel doit « inventer » des pixels intermédiaires. L’interpolation classique — bilinéaire ou bicubique — produit ce résultat mou et en escalier qu’on connaît bien. C’est là que l’IA fait vraiment la différence par rapport aux techniques traditionnelles.

Ce que l’IA fait différemment

La super-résolution par IA repose sur des réseaux de neurones convolutifs (CNN) ou, plus récemment, sur des architectures de type transformeur. Ces modèles ont été entraînés sur des paires d’images : une version haute résolution originale, et la même image délibérément dégradée. Le réseau apprend à reconstruire le détail manquant non pas en interpolant, mais en inférant ce qu’il devrait logiquement se trouver là.

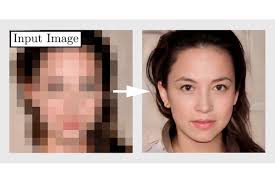

Concrètement, ça veut dire que si vous passez une photo de visage flou dans un bon modèle d’IA, il ne va pas se contenter de lisser les transitions — il va reconstruire les pores de la peau, les cils, les reflets dans l’iris, parce qu’il « sait » à quoi ressemble un visage humain en haute résolution. C’est impressionnant. C’est aussi, parfois, un peu troublant, parce que l’IA hallucine des détails qui n’existaient peut-être pas dans la photo originale.

Super-résolution : multiplier les pixels sans perdre la netteté

Les modèles de super-résolution comme ESRGAN (Enhanced Super-Resolution Generative Adversarial Network) ou Real-ESRGAN peuvent quadrupler la résolution d’une image tout en préservant — et souvent en améliorant — la netteté perçue. Ces outils sont intégrés dans des logiciels grand public comme Topaz Photo AI, Lightroom (via son module Enhance), ou encore des services en ligne accessibles sans installation.

Pour les photographes qui travaillent avec des clients exigeants ou des formats d’impression large, c’est un changement concret dans le flux de travail. Une photo prise avec un téléphone, recadrée de façon agressive, peut aujourd’hui être montée en A3 sans artefacts visibles.

Déflou : récupérer la netteté perdue

Le défloutage est techniquement plus difficile que la super-résolution, parce que le bougé introduit une dégradation directionnelle et non uniforme. Les modèles d’IA modernes utilisent des techniques de déconvolution apprise pour estimer le noyau de flou propre à chaque image, puis inverser son effet. Les résultats varient selon la sévérité du flou, mais sur des bougés modérés — le genre qui rend un portrait utilisable si on arrivait à le corriger — les outils actuels récupèrent un niveau de détail qui aurait été inaccessible il y a trois ans.

Adobe a intégré des fonctions de ce type dans la réduction de flou de caméra de Photoshop, et des outils spécialisés comme DxO PureRaw poussent plus loin avec des modèles entraînés spécifiquement sur les profils de capteurs et d’objectifs les plus courants.

Les limites à connaître avant de se lancer

L’enthousiasme est justifié, mais quelques points méritent d’être posés clairement.

D’abord, l’IA ne récupère pas de l’information qui n’existe pas. Si une photo est prise à ISO 12800 avec un objectif bas de gamme dans l’obscurité, le modèle va faire de son mieux, mais il ne peut pas reconstruire la vérité. Il va produire quelque chose de plausible, souvent de bel aspect, mais qui s’éloigne parfois du sujet réel. Pour le photojournalisme ou la photographie médico-légale, c’est un problème sérieux. Pour le portrait de famille destiné à être encadré, c’est probablement acceptable.

Ensuite, ces traitements sont coûteux en ressources. Les logiciels de bureau sérieux — Topaz, ON1, DxO — demandent une carte graphique correcte. Les services en ligne contournent ça côté utilisateur, mais ils impliquent d’uploader des photos personnelles sur des serveurs tiers, ce qui soulève des questions légitimes sur la vie privée.

Enfin, les artefacts d’IA existent et ils sont parfois difficiles à détecter au premier coup d’œil. Un visage trop lisse, des textures qui se répètent légèrement, des transitions contre-nature entre zones nettes et floues — autant d’indices qui trahissent un traitement agressif. Les photographes expérimentés les repèrent. Le grand public, moins.

Quels outils utiliser en pratique

Le marché a explosé ces deux dernières années et il y a aujourd’hui des options pour tous les budgets et tous les niveaux techniques.

Pour les utilisateurs qui veulent une solution tout-en-un sans prise de tête, les outils d’ia amelioration photo en ligne permettent d’obtenir des résultats corrects en quelques clics, sans installation ni connaissances techniques. On dépose la photo, le modèle tourne en cloud, on récupère le fichier amélioré.

Pour les photographes qui traitent des volumes importants ou qui ont besoin de résultats plus fins, des logiciels comme Topaz Photo AI combinent défloutage, réduction de bruit et super-résolution dans une interface claire. Le modèle analyse automatiquement chaque image et choisit les corrections adaptées. C’est un investissement, mais le rapport qualité/résultat est difficile à contester.

Lightroom Classic et Lightroom CC ont intégré leur propre moteur de super-résolution (la fonction « Améliorer » dans le menu contextuel sur une photo RAW). Les résultats sont bons, surtout sur des images RAW bien exposées, et l’intégration dans le flux de travail existant d’un photographe est un avantage réel.

La restauration de photos anciennes : un cas d’usage à part

Un domaine où l’IA produit des résultats particulièrement saisissants, c’est la restauration de photos argentiques numérisées — celles des albums de famille, tirages abîmés, négatifs rayés. Les modèles entraînés spécifiquement sur des photos historiques savent reconnaître le grain argentique, les déchirures, les taches d’humidité, et les corriger de façon convaincante.

Des outils comme MyHeritage Photo Enhancer ou Remini ciblent explicitement ce segment. Pour quelqu’un qui veut retrouver le visage d’un grand-parent sur une photo de mariage de 1955, les résultats peuvent être émouvants. La qualité n’est pas parfaite — les visages ont parfois une touche de « tableau de peinture numérique » — mais c’est infiniment mieux que laisser la photo se dégrader dans un tiroir.

Des chercheurs du MIT et de Google ont publié des travaux sur la colorisation et la restauration automatisée de photos historiques, montrant que les modèles de diffusion apportent un gain qualitatif significatif par rapport aux GAN de première génération sur ce type de contenu.

Ce que ça change pour les photographes et les non-photographes

Pour un photographe semi-professionnel ou professionnel, l’IA n’est pas un substitut à la technique — c’est un filet de sécurité. Elle ne justifie pas de bâcler la prise de vue. Mais elle permet de sauver des clichés qui auraient autrefois été jetés. Et dans un contexte de reportage ou d’événementiel où on ne peut pas refaire la scène, c’est une différence réelle.

Pour le grand public, c’est encore plus simple : la distance entre « une photo ratée » et « une photo utilisable » s’est considérablement réduite. Les smartphones intègrent déjà ces algorithmes dans leur traitement natif — Google Photo avec son moteur Tensor, Apple avec son processeur Neural Engine et ses modes de photographie computationnelle. La plupart des utilisateurs bénéficient de l’IA sur leurs photos sans même le savoir.

La question qui fâche : jusqu’où va l’authenticité ?

Il y a une conversation qui mérite d’être tenue honnêtement. Quand un modèle d’IA « invente » des pixels plausibles pour remplacer des données perdues, la photo résultante est-elle encore la même photo ? Pour une photographie artistique ou familiale, la réponse est probablement : on s’en fiche, tant que le résultat est beau. Pour une photographie documentaire ou journalistique, c’est plus compliqué.

Le World Press Photo a mis à jour ses règles de concours pour encadrer l’usage de l’IA, reconnaissant que la frontière entre correction technique acceptable et manipulation substantielle est devenue floue — c’est le cas de le dire.

C’est un débat qui va continuer, et il n’y a pas de réponse universelle. Ce qu’on peut dire avec certitude, c’est que les outils existent, qu’ils fonctionnent, et que savoir les utiliser de façon éclairée — en comprenant ce qu’ils font et ce qu’ils ne font pas — est devenu une compétence utile pour quiconque travaille avec des images.

Conclusion

L’amélioration photo par IA n’est plus une technologie de niche réservée aux labos de recherche. C’est un ensemble d’outils accessibles, efficaces sur des cas concrets, et qui s’améliorent de façon visible d’une génération à l’autre. Pour les photos floues ou pixelisées qui dormaient dans vos archives en attendant une solution, c’est le bon moment de les ressortir.

Les limites existent et méritent d’être comprises. Mais dans l’ensemble, quand on compare ce qu’il était possible de faire il y a cinq ans avec ce que permettent aujourd’hui les outils d’ia amelioration photo, la conclusion s’impose : la donne a effectivement changé.

Bonjour, je m’appelle Manu Dibango et j’ai 37 ans. Cadre supérieur dans l’administration, je suis passionné par la gestion et l’organisation. Bienvenue sur Camernews où je partage ma veille sur les nouvelles technologies et l’innovation.