Une nouvelle étude d’Apple révèle comment des robots apprennent à agir en observant les humains, révolutionnant l’interaction homme-machine. Cette avancée promet des applications variées, de l’assistance à la maison à la robotique industrielle. Les implications éthiques et pratiques soulèvent des questions fascinantes pour l’avenir de la technologie.

Robot voir, robot faire

Le projet concerne une collaboration entre Apple, MIT, Carnegie Mellon, l’Université de Washington et UC San Diego. Cette étude vise à explorer comment les séquences vidéos montrant des personnes manipulant des objets peuvent être utilisées pour entraîner des modèles de robots humanoïdes à usages multiples.

Les chercheurs ont rassemblé plus de 25 000 démos humaines et 1 500 démos de robots, constituant un ensemble de données appelé PH2D. Ces données ont été intégrées dans une politique d’IA unifiée, pouvant alors contrôler un vrai robot humanoïde dans le monde physique.

Selon les auteurs de l’étude :

Former des politiques de manipulation pour des robots humanoïdes à partir de données diverses renforce leur robustesse et leur capacité à généraliser à travers différentes tâches et plateformes. Cependant, apprendre uniquement à partir de démos de robots est laborieux et nécessite une collecte de données téléopérées coûteuse, difficile à mettre à l’échelle.

Ce travail explore une source de données plus évolutive, les démonstrations humaines égocentriques, pour servir de données d’entraînement inter-embodiment pour l’apprentissage des robots.

Ainsi, l’idée fondamentale est de laisser les humains montrer la voie.

Un entraînement plus rapide et moins coûteux

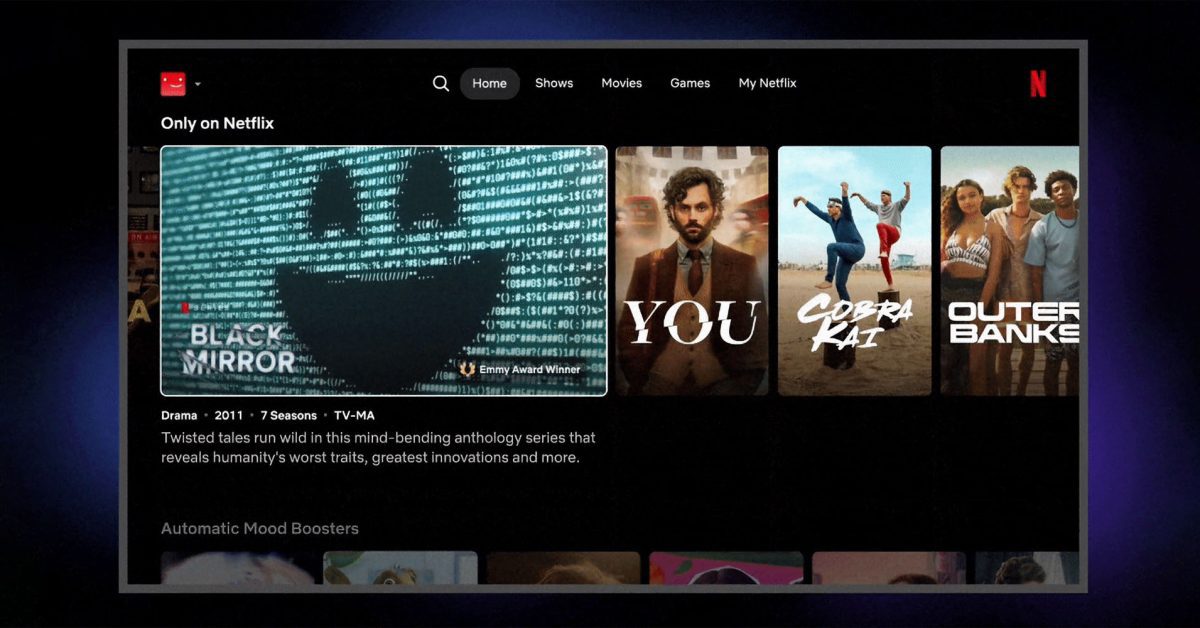

Pour collecter les données d’entraînement, l’équipe a développé une application Apple Vision Pro qui capture des vidéos depuis la caméra inférieure gauche de l’appareil, utilisant le framework ARKit d’Apple pour suivre les mouvements en 3D de la tête et des mains.

Pour explorer une solution plus économique, ils ont également imprimé en 3D un support pour fixer une caméra ZED Mini Stereo à d’autres casques, comme le Meta Quest 3, permettant ainsi de suivre les mouvements en 3D à un coût réduit.

Cette configuration a permis d’enregistrer des démonstrations de haute qualité en quelques secondes, montrant une amélioration significative par rapport aux méthodes traditionnelles de téléopération des robots, souvent plus coûteuses et plus lentes.

Un dernier détail intéressant : puisque les humains se déplacent beaucoup plus rapidement que les robots, les chercheurs ont ralenti les démonstrations humaines d’un facteur de quatre lors de l’entraînement, juste assez pour que le robot puisse suivre sans nécessiter d’autres ajustements.

Le Transformateur d’Action Humaine (HAT)

Le cœur de l’étude repose sur le HAT, un modèle entraîné sur des démonstrations humaines et robotiques sous un format partagé.

Au lieu de séparer les données par source (humains contre robots), le HAT apprend une politique unique qui se généralise aux deux types de corps. Cela rend le système plus flexible et efficace en termes de données.

Dans certains tests, cette approche d’entraînement partagé a permis au robot de gérer des tâches plus complexes, y compris celles qu’il n’avait jamais rencontrées auparavant, en comparaison avec des méthodes plus traditionnelles.

En somme, cette étude offre un éclairage fascinant sur l’avenir des robots humanoïdes et leur capacité à apprendre par l’observation humaine. Pour plus d’informations sur ce sujet, consultez [l’article de recherche](https://human-as-robot.github.io).

Comment Apple utilise-t-il les démonstrations humaines pour former des robots humanoïdes ?

Apple, en collaboration avec plusieurs universités, collecte des démonstrations humaines pour entraîner des robots. En utilisant des vidéos de personnes manipulant des objets, ils alimentent un modèle d’IA qui peut contrôler un robot humanoïde dans le monde physique.

Qu’est-ce que le Human Action Transformer (HAT) ?

Le HAT est un modèle qui apprend à partir de démonstrations humaines et robotiques dans un format commun. Il permet au robot d’adopter une politique unique et flexible, améliorant ainsi son efficacité et sa capacité à réaliser des tâches variées.

Comment le projet améliore-t-il la collecte de données d’entraînement ?

Le projet a développé une application pour Apple Vision Pro qui capture des vidéos en utilisant la réalité augmentée pour suivre les mouvements de la tête et des mains. Cela permet de créer des démonstrations de haute qualité rapidement, économisant ainsi du temps et des ressources par rapport aux méthodes traditionnelles.

Quel est l’impact des démonstrations humaines sur les performances des robots ?

Les démonstrations humaines, ralenties pour la formation, permettent au robot d’apprendre des tâches plus complexes qu’il n’a jamais rencontrées auparavant, augmentant ainsi sa robustesse et sa capacité d’adaptation.