Découvrez comment les appareils Apple révolutionnent la transcription avec des fonctionnalités de conversion de la parole en texte dans les versions bêta pour développeurs. Optimisés pour une lisibilité améliorée, ces outils pourraient redéfinir la manière dont nous interagissons avec la technologie, transformant les communications du quotidien en expériences fluides et accessibles.

Si vous avez déjà besoin de transcrire de l’audio ou de la vidéo en texte, la plupart des applications actuelles reposent sur le modèle Whisper d’OpenAI. Ce modèle est probablement utilisé par des applications telles que MacWhisper, qui vous permettent de transcrire des réunions ou des cours, ou même de générer des sous-titres pour des vidéos YouTube.

Cependant, iOS 26 et d’autres versions bêta de développeur d’Apple intègrent les propres frameworks de transcription de l’entreprise. Des tests suggèrent que ces nouveaux outils atteignent une précision comparable à celle de Whisper tout en fonctionnant à plus du double de la vitesse.

Les capacités de dictée intégrées à vos appareils Apple sont gérées par le framework de parole d’Apple. Dans les nouvelles versions bêta, il existe des versions bêta de SpeechAnalyzer et SpeechTranscriber, que les développeurs peuvent utiliser dans leurs propres applications.

Utilisez le framework de parole pour reconnaître les mots parlés dans des fichiers audio enregistrés ou en direct. Le support de dictée du clavier utilise la reconnaissance vocale pour traduire le contenu audio en texte. Ce framework propose un comportement similaire, sauf que vous pouvez l’utiliser sans avoir besoin d’un clavier.

Par exemple, vous pouvez utiliser la reconnaissance vocale pour identifier des commandes verbales ou pour gérer la dictée de texte dans d’autres parties de votre application. Le framework fournit une classe, SpeechAnalyzer, ainsi que plusieurs modules pouvant être ajoutés à l’analyseur pour offrir des types d’analyses et de transcriptions spécifiques. De nombreux cas d’utilisation nécessitent uniquement un module SpeechTranscriber, qui fournit des transcriptions audio-texte.

Dans un article publié sur MacStories, John Voorhees a demandé à son fils de créer un outil en ligne de commande pour tester cette nouvelle fonctionnalité, et les résultats l’ont véritablement impressionné.

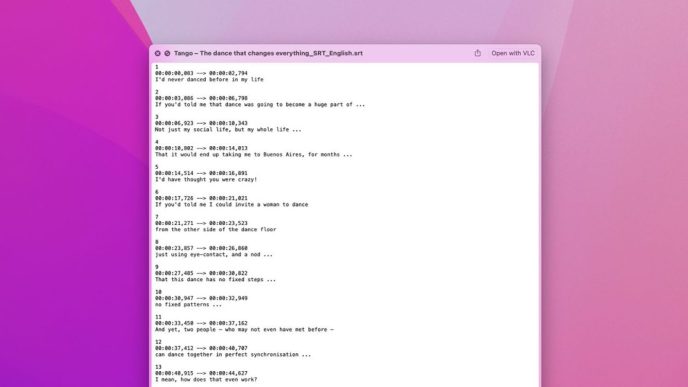

J’ai demandé à Finn ce qu’il faudrait pour construire un outil en ligne de commande afin de transcrire des fichiers vidéo et audio avec SpeechAnalyzer et SpeechTranscriber. Il a estimé que cela prendrait environ 10 minutes, et il n’était pas loin du compte. Au final, il m’a fallu plus de temps pour installer macOS Tahoe après la WWDC que pour que Finn développe Yap, un utilitaire en ligne de commande simple qui prend des fichiers audio et vidéo comme entrée et produit des transcriptions formatées en SRT et TXT.

Finn a utilisé une vidéo de 34 minutes pour tester cet outil contre MacWhisper et VidCap, deux des applications de transcription les plus populaires. Il a découvert que les modules d’Apple égalaient la précision de ces applications, tout en étant plus de deux fois plus rapides que l’application la plus efficace existante, MacWhisper, utilisant le modèle Large V3 Turbo :

| Application | Temps de Transcription |

|---|---|

| Yap (utilisant le framework d’Apple) | 0:45 |

| MacWhisper (Large V3 Turbo) | 1:41 |

| VidCap | 1:55 |

| MacWhisper (Large V2) | 3:55 |

Bien que cela puisse sembler une amélioration relativement triviale pour des tâches ponctuelles, les différences s’accumulent rapidement lors de transcriptions en lot ou lorsque des fichiers doivent être transcrits régulièrement, comme c’est souvent le cas avec les notes de cours des étudiants.

Si vous exécutez la version bêta de développeur de macOS Tahoe, vous pouvez installer Yap sur GitHub pour tester par vous-même cette fonctionnalité révolutionnaire.

Accessoires mis en avant

Image : capture d’écran de 9to5Mac d’un fichier de sous-titres d’une vidéo YouTube.

FTC : Nous utilisons des liens affiliés pour générer des revenus.

### Quelle est la précision de la reconnaissance vocale d’Apple par rapport à Whisper ?

La précision des nouveaux cadres de transcription d’Apple correspond à celle de Whisper, tout en fonctionnant à plus de deux fois la vitesse de ce dernier.

### Quels outils les développeurs peuvent-ils utiliser pour la transcription ?

Les développeurs peuvent utiliser les versions bêta de **SpeechAnalyzer** et **SpeechTranscriber** dans leurs propres applications pour la reconnaissance vocale et la transcription.

### Combien de temps prend la transcription avec Yap d’Apple par rapport à d’autres applications ?

L’application Yap utilisant les modules d’Apple a pris 45 secondes pour transcrire un fichier, tandis que MacWhisper a pris 1 minute et 41 secondes, et VidCap 1 minute et 55 secondes.

### Qui a testé la capacité de transcription d’Apple ?

John Voorhees, de MacStories, a demandé à son fils de créer un outil en ligne de commande pour tester cette nouvelle capacité et a été impressionné par les résultats.