Dans un monde où l’ergonomie numérique est cruciale, Apple teste ses assistants AI pour anticiper les conséquences d’utilisation des applications. Cette innovation vise à optimiser la lisibilité et l’expérience utilisateur, révélant l’engagement de la marque envers l’amélioration continue et l’adaptation aux besoins des consommateurs modernes.

Les tests d’Apple sur les assistants IA et leur capacité à anticiper les conséquences des actions sur les applications

Contexte des tests

Dans un monde où les agents IA se rapprochent progressivement de l’exécution d’actions réelles en notre nom, un récent étude coécrite par Apple s’intéresse à la manière dont ces systèmes comprennent réellement les conséquences de leurs actions. Présentée lors de la conférence ACM sur les interfaces utilisateur intelligentes en Italie, la recherche, intitulée « De l’interaction à l’impact : vers des agents IA plus sûrs grâce à la compréhension et à l’évaluation des impacts des opérations UI mobiles », introduit un cadre détaillé pour analyser les résultats des interactions entre un agent IA et une interface mobile.

Compréhension des conséquences

L’originalité de cette étude réside dans sa capacité à explorer non seulement si les agents peuvent appuyer sur le bon bouton, mais également s’ils peuvent anticiper les conséquences de leurs actions et évaluer si cela devrait se faire. Les chercheurs soulignent que bien que des recherches antérieures se soient concentrées sur la navigation des IU par des IA, les impacts réels des actions autonomes des agents, notamment celles qui peuvent être risquées ou irréversibles, sont souvent sous-explorés.

Classification des interactions risquées

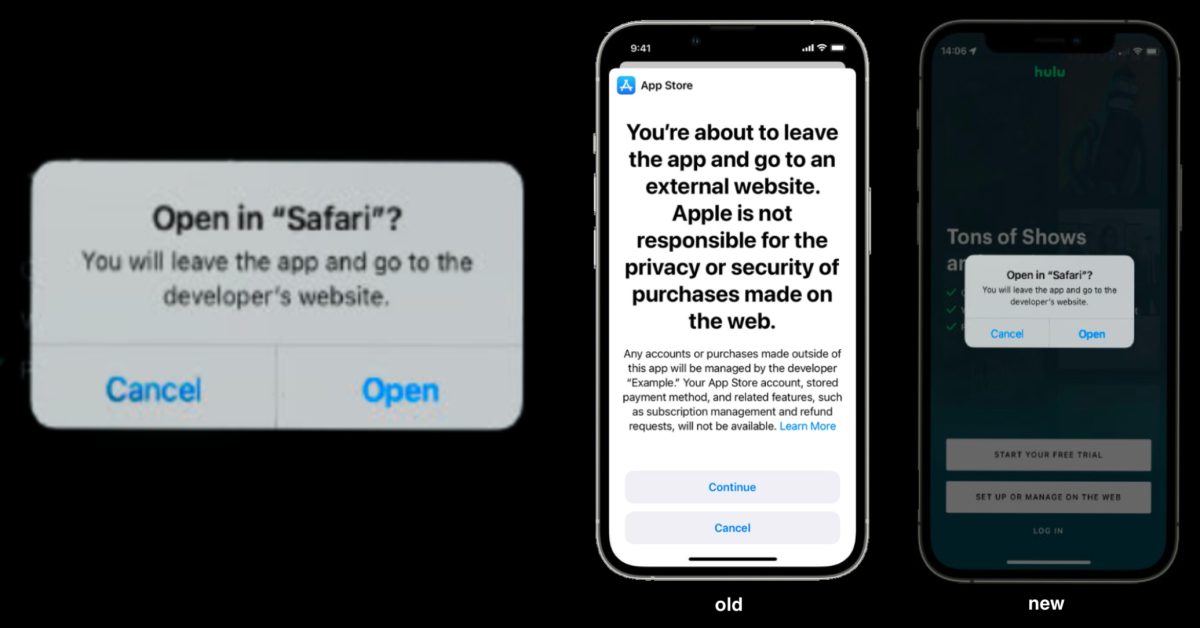

La recherche met en lumière que de nombreux ensembles de données utilisés pour former des agents UI se composent principalement d’actions relativement inoffensives, comme faire défiler une liste ou ouvrir une application. Les participants recrutés au cours de cette étude ont été chargés d’utiliser de vraies applications mobiles et d’enregistrer des actions susceptibles de les rendre mal à l’aise si elles étaient exécutées par une IA sans leur accord. Des actions telles que l’envoi de messages, la modification de mots de passe ou la réalisation de transactions financières étaient soumises à évaluation.

Chaque action a été étiquetée selon un cadre de classification qui prend non seulement en compte l’impact immédiat sur l’interface, mais également des facteurs importants comme :

-

Intention de l’utilisateur : Quel est l’objectif de l’utilisateur ? Est-ce informatif, transactionnel, communicatif ou simplement de la navigation basique ?

-

Impact sur l’UI : L’action change-t-elle l’apparence de l’interface, les informations affichées ou la destination de l’utilisateur ?

-

Impact sur l’utilisateur : Cela pourrait-il affecter la vie privée, les données, le comportement ou les actifs numériques de l’utilisateur ?

-

Réversibilité : Si quelque chose se passe mal, peut-on facilement annuler l’action ? Ou pas du tout ?

- Fréquence : Est-ce une action effectuée de temps à autre ou régulièrement ?

Ainsi, le cadre développé permet aux chercheurs d’évaluer si les modèles prennent en compte des éléments tels que : « Cela peut-il être annulé d’un simple geste ? » ou « Y a-t-il un impact visible pour autrui ? », avant d’agir au nom de l’utilisateur.

Évaluation du jugement de l’IA

Une fois cet ensemble de données constitué, l’équipe a testé cinq modèles de langage avancés, incluant GPT-4 et Google Gemini, ainsi que le modèle d’Apple, Ferret-UI. L’objectif était d’évaluer la compétence de ces modèles à classifier l’impact de chaque action.

Les résultats ont montré que Google Gemini a obtenu de meilleures performances dans des tests dits « zéro-shot », atteignant 56 % de précision, tandis que la version multimodale de GPT-4 a surpassé les autres avec une précision de 58 % lorsqu’il était invité à raisonner étape par étape en utilisant des techniques de raisonnement.

Implications pour les agents IA

À mesure que les assistants vocaux et agents s’améliorent dans l’application de commandes en langage naturel, la véritable défi de sécurité réside dans leur capacité à savoir quand demander une confirmation ou, dans certains cas, quand s’abstenir d’agir. Bien que cette étude ne résolve pas entièrement le problème, elle propose un standard mesurable d’évaluation sur la compréhension par les modèles des enjeux de leurs actions.

Parallèlement, alors qu’une quantité considérable de recherches se concentre sur l’alignement des IA, qui vise à garantir que les agents agissent selon les véritables désirs des humains, la recherche d’Apple apporte une nouvelle dimension. Elle interroge les capacités des agents IA à anticiper les résultats de leurs actions et leurs décisions basées sur ces informations avant de passer à l’acte.

Références

Pour des informations supplémentaires sur la sécurité des IA et leur impact sur l’utilisateur, visitez NIST, qui propose des directives sur ces technologies émergentes.

Quels sont les principaux résultats de l’étude sur les agents d’IA ?

L’étude révèle que les agents d’IA ne doivent pas seulement interagir avec les interfaces utilisateur, mais aussi anticiper les conséquences de leurs actions et décider si elles doivent aller de l’avant.

Comment les interactions risquées ont-elles été classées dans l’étude ?

Les interactions risquées ont été classées en tenant compte de l’intention de l’utilisateur, de l’impact sur l’interface, de l’impact sur l’utilisateur, de la réversibilité et de la fréquence des actions effectuées.

Quels modèles d’IA ont été testés dans cette recherche ?

Les chercheurs ont testé cinq modèles de langage, y compris GPT-4 et Google Gemini, pour évaluer leur capacité à classifier correctement l’impact des actions sur une interface mobile.

Quel est l’enjeu principal pour la sécurité des agents d’IA ?

L’enjeu central est de s’assurer que les agents d’IA savent quand demander une confirmation ou quand ne pas agir du tout, afin de garantir une interaction sécurisée avec l’utilisateur.